Je größer der Wald, umso aufwändiger seine Inventur: Der Staatsforst von Bayern wird alle zehn Jahre vermessen und statistisch erfasst. Dazu machen sich 21 Försterinnen und Förster zu 8000 festgelegten Standorten auf, sammeln dort Informationen über etwa 100.000 Bäumen, bewerten zum Beispiel Art, Größe, Zustand, zudem die Vegetation im Umfeld. Das kostet viel Zeit und Geld. Der Wald könnte in Zukunft regelmäßiger vermessen und insbesondere Schäden könnten schneller erkannt werden: von oben und mit digitalen Werkzeugen: „Noch gelingt niemandem in Bayern oder Deutschland eine zeitnahe, flächendeckende Bestandsaufnahme von Waldstörungen mit Satellitendaten“, stellt Nikolas Herbst, Akademischer Rat am Lehrstuhl Software Engineering der Julius-Maximilians-Universität Würzburg fest. Er arbeitet beim interdisziplinären Projekt „Real-Time Earth Observation of Forest Dynamics and Biodiversity” (ROOT) mit, an dem, auch das Deutsche Fernerkundungsdatenzentrum (DFD) beteiligt ist, und setzt dabei terrabyte ein, die Hochleistungsplattform für die Analyse von Erdbeobachtungsdaten am Leibniz-Rechenzentrum (LRZ). Für ROOT werten Herbst und seine Kolleginnen Multispektraldaten der Sentinel- und Landsat-Satelliten aus. Diese kombiniert das Team mit Informationen vom Deutschen Wetterdienst (DWD), aus Insektenfallen und anderen Quellen. Etwa alle 14 Tage liegen genügend neue Aufnahmen der Satelliten vor, um die Daten über den Wald zu aktualisieren. Ziel ist, einen automatisierten, digitalen Inforamtionsdienst für bayerische Wälder zu schaffen, der das kontinuierliche Monitoring ermöglicht.

Der Wald, genauer: der Bayerische Wald und sein Nachbar Šumava (Böhmerwald) und der eigene Universitätsforst, steht an der Ludwig-Maximilians-Universität (LMU) ebenfalls im Mittelpunkt. Für die Regulus-Forschungsprojekte AI-Klima und LabForest kombiniert eine Forschungsgruppe um Professor Lukas Lehnert Light Detecting and Ranging- oder LiDAR-Daten von Flugzeugen mit Satellitendaten sowie Kameras im Wald. Damit analysieren sie Zustand und Entwicklung des Forsts, zeigen Strategien zur Verjüngung auf und entwickeln überdies generelle statistische Auswertungsverfahren für Daten aus der Erdbeobachtung, etwa zur Bestimmung von Biomasse oder wie Wald die Hydrologie einer Region beeinflusst: „Es geht um neue Methoden für die Berechnung und Bearbeitung von Satellitendaten, auf deren Grundlage wiederum KI- oder mathematisch-physikalische Modelle erarbeitet werden können“, spezifiziert Lehnert das Ziel. Wie ROOT arbeitet sein Team mit terrabyte: „Die Plattform ermöglicht den Einsatz eigener Datensätze, Auswertungsroutinen und Algorithmen in verschiedenen Programmiersprachen“, beschreibt Lehnert. „Die Ergebnisse können einfach heruntergeladen oder mit eigenen Tools weiterverarbeitet werden.“

terrabyte ist ein Projekt vom Deutschen Zentrum für Luft- und Raumfahrt (DLR) und dem LRZ. 2019 konzeptioniert und danach am LRZ installiert, ging die Plattform 2023 in den Betrieb: „Das LRZ hostet und betreibt die Infrastruktur sowie Basisdienste wie die Authentifizierung, die Planung von Aufträgen sowie das webbasierte Rechenportal, das DLR ist fürs Datenmanagement, spezifische Webdienste zur Analyse und Verarbeitung von Erdbeobachtungsdaten sowie den Benutzersupport zuständig“, beschreibt Maximilian Schwinger die Arbeitsteilung. Der Informatiker betreut und entwickelt beim DLR zusammen mit Dr. Jonas Eberle terrabyte weiter: „Die Plattform ist ein Hybrid zwischen Cloud und High-Performance Computing.“ terrabyte kombiniert ein Supercomputing-Cluster aus 44.000 virtuellen CPU-Kernen und 188 NVIDIA-GPU mit einem Speicher, in dem rund 50 Petabyte Daten und Bilder von diversen Erdbeobachtungsmissionen und Satelliten (Copernicus, Landsat, Modis, Sentinel, VIIRS) lagern. Durch eine schnelle Datenleitung zwischen Oberpfaffenhofen und Garching können Forschende zusätzlich auf das gut gefüllte DLR-Archiv zugreifen. Die Plattform wird von Mitarbeitenden des DLR genutzt und steht per Antrag dem LRZ-Nutzungskreis offen: „Eine Evaluation hat gezeigt, dass terrabyte den passenden technischen Ansatz verfolgt“, erläutert Eberle. „Die Ausstattung der Plattform ist nicht hochkomplex, sondern auf ihren Einsatz in der Forschung abgestimmt. Wir können damit autarker von US-Angeboten werden.“

Näher betrachtet bietet terrabyte eine Alternative zu den die Angeboten von Hyperscalern wie Amazon oder Google. Auch deren Plattformen stellen Werkzeuge zur Auswertung von Bild- und anderen Daten bereit, hier können eigene Codes und Algorithmen entwickelt oder implementiert werden. Aber: „Wir haben mit der Google Earth-Engine gearbeitet“, berichtet Lehnert. „Das war ziemlich umständlich, die Möglichkeiten waren begrenzt, und am Ende konnte man Ergebnisse nur schwer herunterladen.“ Um Kunden an sich zu binden, setzen Digital-Konzerne auf so genanntes Vendor-Lock-in, sie gestalten Dienstleistungen und Technik so, dass ein Wechsel zu Alternativen umständlich wird: Um Wissenschaft unabhängiger von solchen Diensten zu machen, startete vor sechs Jahren das Projekt terrabyte – eine vorausschauende Entscheidung: „Momentan passiert politisch sehr viel“, beobachtet DLR-Mann Schwinger. „Wir wissen nicht, welche Daten und Plattformen in den USA künftig den Europäern zur Verfügung stehen.“

Durch Stellen- und Mittelkürzungen in Behörden und Institutionen wie der National Oceanic and Atmospheric Administration (NOAA), die drei Satellitenprogramme verantwortet und bisher ihre Wetter- und Klimadaten weltweit verbreitete, werden Programme enorm eingeschränkt oder der Informationsfluss unterbrochen. Auch die Daten zur Luftqualität, die US-Botschaften weltweit sammelten, stehen nicht mehr zur Verfügung oder müssen künftig eventuell bezahlt werden. Hinzu kommen Risiken durch aufkommenden Zollstreit: Sollte Europa digitale Dienste mit Abgaben belegen, könnte sich das Forschen mit den Hyperscalern verteuern; umgekehrt weigern sich High-Tech-Konzerne, Europas Gesetze rund um die Digitalisierung (Datenschutz, Moderation von Information, AI Act u.a.) vollständig einzuhalten. „Forschung ist von wachsenden Datensätzen abhängig, KI-Anwendungen erhöhen das Datenvolumen zusätzlich. Folglich braucht es zur Verarbeitung ausreichend Rechen- und Speicherkapazitäten“, sagt LMU-Professor Lehnert. „Wenn wir international mithalten wollen, kommen wir nicht umhin, noch mehr Plattformen wie terrabyte aufzubauen.“ Noch ist terrabyte in Deutschland einzigartig, aber in Hessen wird ein vergleichbares System vorbereitet; auch in Europa werden vergleichbare Angebote aufgebaut und daran gearbeitet, diese miteinander zu verbinden. „terrabyte“, fasst Software-Spezialist und Gutachter Herbst seine Erkenntnisse mit terrabyte zusammen, „leistet einen Riesenbeitrag zur Umwelt- und Klimaforschung. Daraus einen Mehrwert für Organisationen, Behörden und für Unternehmen zu generieren, ist die nächste große Aufgabe im ROOT-Projekt.“

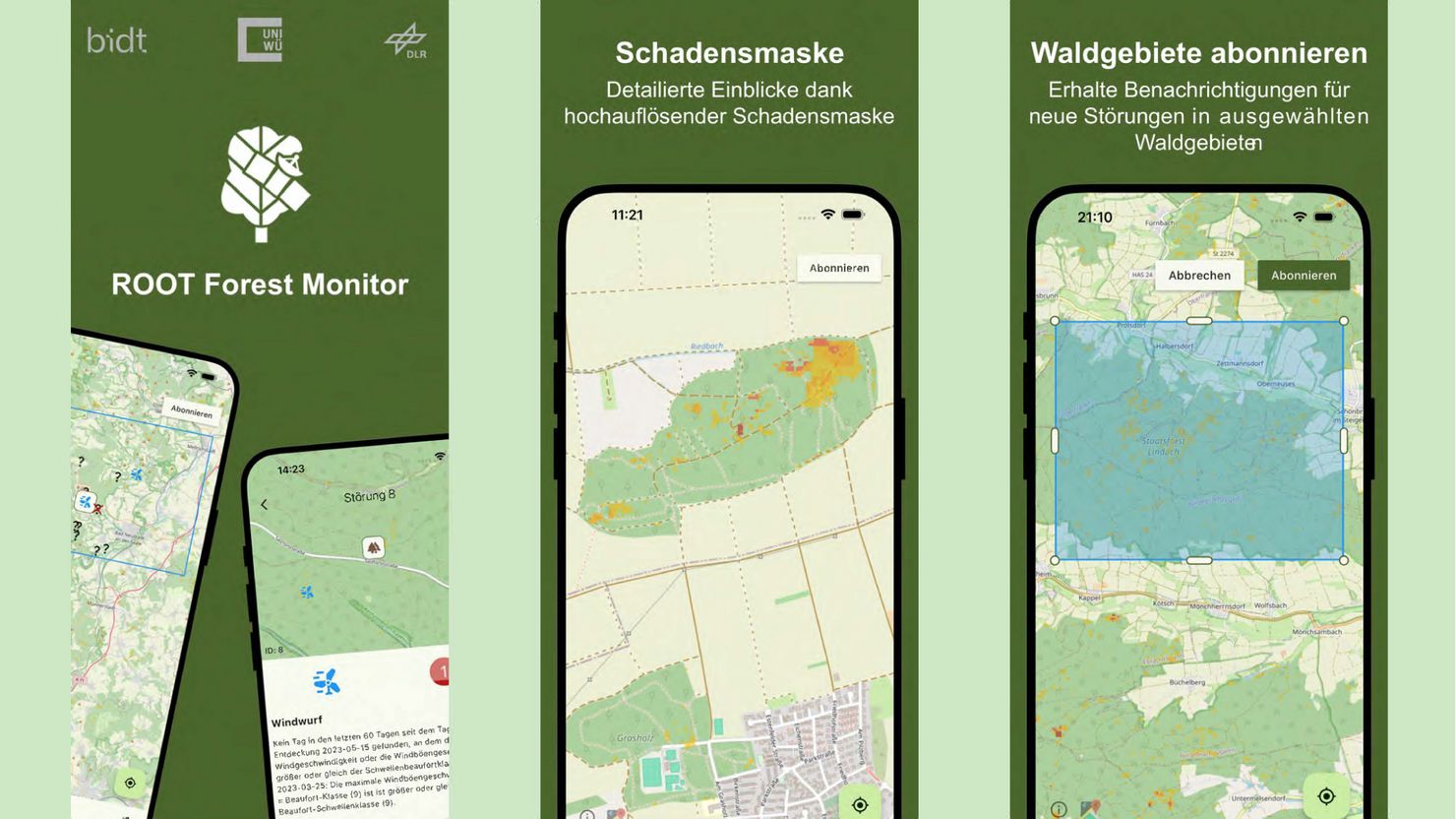

Das Wald-Projekt hat seit 2023 modulare Workloads für die Prozessierung von Bilddaten aus unterschiedlichsten Quellen aufgebaut. Mit terrabyte zunächst Langzeitdaten aus dem DLR-Archiv verarbeitet, damit Zeitreihen ausgehend von den Dürrejahren ab 2018 abgeleitet und so die Grundlagen für eine stetige Auswertung aktueller Satellitendaten geschaffen. Außerdem wurde eine App entwickelt, die in übersichtlichen Karten Schäden in den Wäldern Bayerns aufzeigt: „Wir wollen schnell auf Symptome wie Schneebruch, Trockenheit, Windschäden, Brand oder Insektenbefall reagieren können“, erklärt Herbst. „Während Staatswälder systematisch kontrolliert werden, können viele Wälder im Privatbesitz nicht engmaschig gemanagt werden. Das erschwert die zeitnahe Erfassung von Schäden und verzögert notwendiges Eingreifen.“ Krankheiten könnten sich folglich schneller ausbreiten. Die ROOT-App (Bild oben), die sich inzwischen in der Erprobungsphase befindet und alle 14 Tage aktualisiert wird, soll Waldbesitzer ansprechen. An einer webbasierten Desktop-Variante des Programms wird gerade gearbeitet, für sie interessiert sich die Verwaltung des Nationalparks Bayerischer Wald, eine Partnerin von ROOT. terrabyte ist zum unverzichtbaren Werkzeug geworden, durch die Analyse weiterer Satelliten- und Umweltdaten werden immer mehr Informationen zum Wald digital verfügbar.

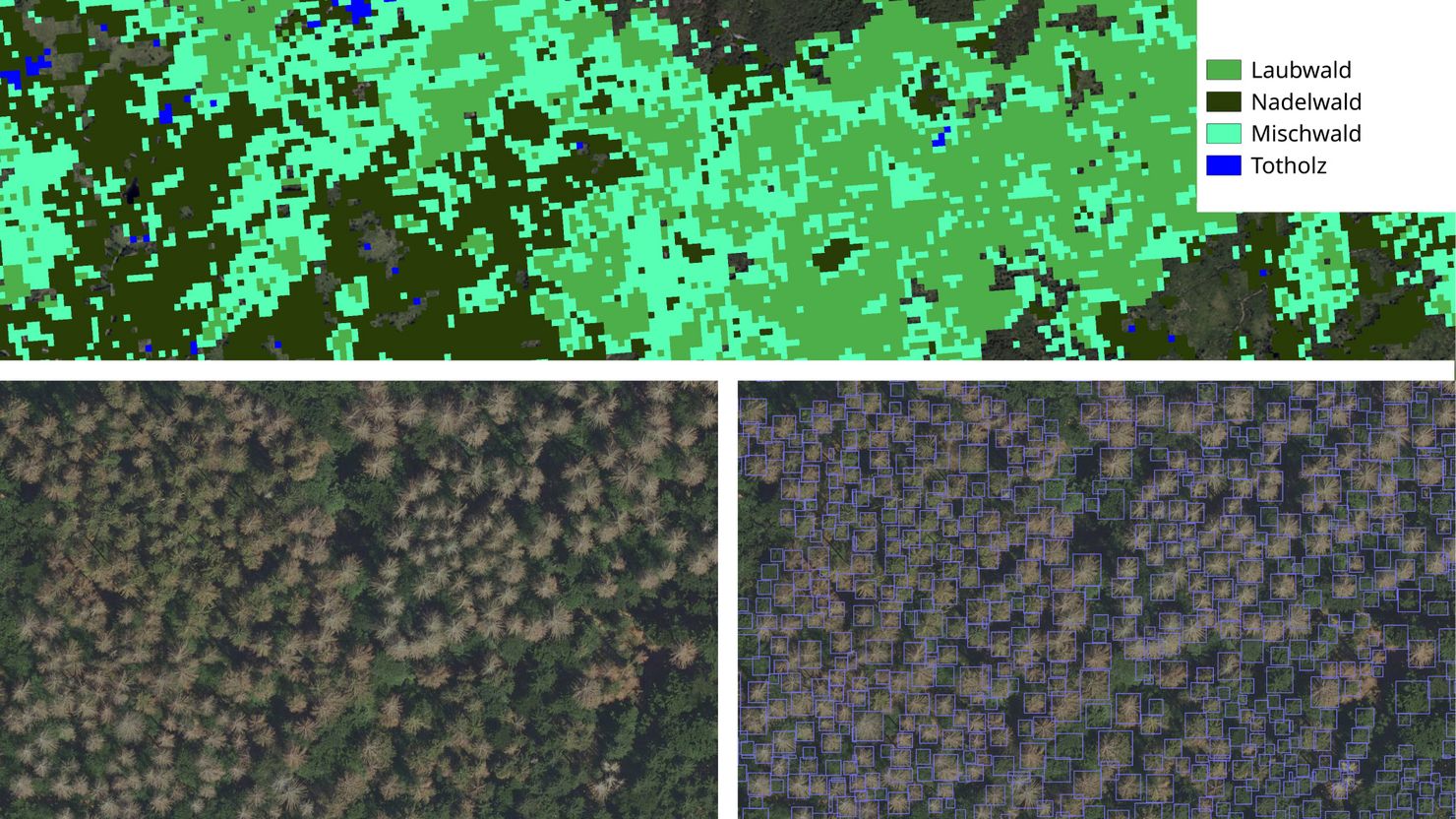

Das Team um Lehnert untersucht, wie sich der Wald zwischen 2000 und 2023 durch den Klimawandel, den Borkenkäfer und weitere Einflüsse verändert hat: Dafür betrachten die Forschenden im AI-Klima Projekt hochaufgelöste, verzerrungsfreie und georeferenzierte Luftbilder vom Bayerischen Wald und vom Nationalpark Šumava, auf denen einzelne Bäume zu erkennen sind, und vergleichen sie mit Multispektraldaten aus den Landsat-Missionen. Allein für den Bayerischen Wald kommt pro Jahrgang dadurch ein Datenvolumen von 1,4 Terabyte zusammen. Um solche Datenmengen händeln zu können, ist terrabyte mit einem Arbeitsspeicher von insgesamt 335 Terabyte sowie viel Rechenkraft ausgerüstet, zusätzlich können in einer Cloud ein weiteres Petabyte Daten gelagert und weitere 3000 virtuelle CPU aktiviert werden. Zusammen mit Infiniband-Verbindungen für den Datentransfer ermöglicht diese Ausstattung das Berechnen, Zwischenspeichern und die weitere Auswertung von Daten: „Ob eine Fichte durch den Borkenkäfer gefährdet ist, erkennen wir heute erst, wenn ein Baum schon befallen ist. Den entstehenden Schaden können wir daher nur quantitativ aufnehmen“, umreißt Lehnert Problem und Herausforderung. Sein Team will aus den Bilddaten noch mehr Hinweise oder Wissen herausfiltern. Vielleicht, so die Hoffnung, lässt sich daraus auch die Zusammensetzung von Blättern und Biomasse ablesen, die wiederum Schlüsse auf die Baumgesundheit erlauben könnten.

ROOT und die Studien von Lehnerts Team – erste Paper stellen die Forschenden Ende April auf der EGU25 in Wien vor, einem Kongress rund um die computergestützte Umweltforschung – münden außerdem in die Optimierung der Erdbeobachtung und die Auswertung von Daten. So ist gerade das interdisziplinäre Projekt „Scientific Computing for Earth Observation und Sustainability” (SOS) gestartet. „Wir entwickeln Technik, die in Plattformen wie terrabyte bereitgestellt werden weiter, außerdem generell Tools und Programme für die Erdbeobachtung“, beschreibt Herbst neue Aufgaben. „Man sollte in Zukunft kein Informatiker sein müssen, um mit Hochleistungsplattformen zur Datenanalyse arbeiten zu können.“ Lehnert und seine Kolleginnen entwickeln wiederum Verfahren zur Veredelung und Anreicherung von Satellitendaten mit Informationen aus weiteren Quellen, um damit die Geo- und Klimawissenschaften voranzubringen. Und auch am DLR machen sie sich Gedanken, wie die Nutzung von terrabyte durch Forschende verbessert werden kann. „So eine Plattform ist ja nichts Statisches, sie entwickelt sich kontinuierlich weiter“, meinen Schwinger und Eberle. „In den nächsten Monaten bereiten wir Funktionen vor, mit deren Hilfe Nutzerinnen von terrabyte ihre Datensätze, Algorithmen und KI-Modelle untereinander teilen können.“ Außerdem ist terrabyte inzwischen an vielen Tagen voll ausgelastet, das Management von Wartezeit und die Zuteilung von Ressourcen wird wichtiger, außerdem muss überlegt werden, welche aktuellen Satellitendaten von der Plattform ausgelagert werden können, um mehr Platz zu machen für Informationen aus mehr Erdbeobachtungsprogrammen. (vs)

Bildnachweis: © DLR | Sentinel 1