High-Performance Computing (HPC) ist ein unverzichtbares Werkzeug in der Astrophysik: Forschende, die das Universum besser verstehen möchten, modellieren an Supercomputern Phänomene in unserer Galaxie, die entweder zu groß oder zu komplex sind, um sie auf andere Weise zu untersuchen. So untersuchte ein Forschungsteam um James Beattie, promovierter Astrophysiker an der Princeton University und am Canadian Institute for Theoretical Astrophysics der University of Toronto, wie Magnetfelder die hochgradig turbulenten Bewegungen im interstellaren Medium (ISM) beeinflussen. Wissenschaftlerinnen der Australian National University und der Universität Heidelberg unterstützten diese Arbeit, für die außerdem HPC-Ressourcen am Leibniz-Rechenzentrum (LRZ) zum Einsatz kamen – eines der drei Zentren des Gauss Centre for Supercomputing (GCS).

Die Gruppe modellierte Turbulenzen im ISM in bisher unerreichter Detailgenauigkeit. Die Simulationsergebnisse stellen langjährige Annahmen über die Rolle magnetischer Turbulenz infrage und zeigen auf, wo weitere Forschung für Weltraum-Experimente ansetzen sollte. Die Ergebnisse veröffentlichte das Fachmagazin Nature Astronomy (s.u.). „Das ISM ist letztlich die Quelle, in der neue Sterne entstehen“, fasst Salvatore Cielo, Spezialist für Anwendungssupport im Astrolab des LRZ und Mitautor der Studie, die Bedeutung zusammen. „Zu verstehen, wie dieser Prozess funktioniert, ist ein Problem, das die Astrophysik schon lange beschäftigt und für das sich erste Prinzipien bisher nicht allein durch Theorie ableiten lassen. Mit Hilfe unserer Simulationen können wir nun ein Verhalten der magnetischen Energie vorhersagen, das anderen theoretischen Modellen bislang entgangen ist.“

Physikerinnen betrachten Turbulenz als eine der letzten großen ungelösten Herausforderungen ihres Fachs – und das aus gutem Grund: Die turbulenten Bewegungen von Gasen ähneln denen von Flüssigkeiten und sind von Natur aus chaotisch, das erschwert eine genaue Untersuchung und die Modellierung der gegenseitigen Einflüsse aller Komponenten in allen Skalengrößen. Darüber hinaus zerfallen turbulente Wirbel in immer kleinere Strukturen, in einer Kaskade von großen zu kleinen Strukturen, die sich nur schwer berechnen lässt. Darüber hinaus bringt das ISM Komplexität mit: Die in der Galaxie auftretende Turbulenz wird von Magnetfeldern sogar entfernter Sterne verändert. Auch wenn diese schwach erscheinen, werden sie wie durch einen rotierenden Dynamo in den turbulenten Wirbeln des ISM verstärkt.

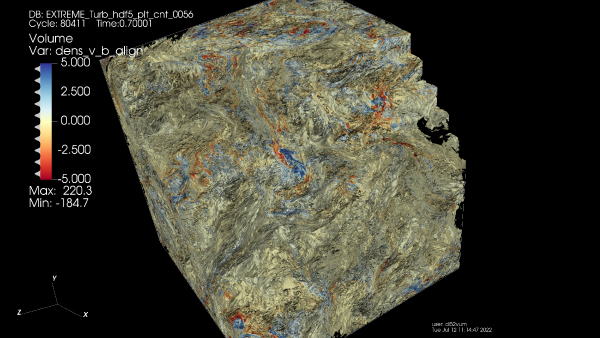

3D-Bilder aus der Simulation verdeutlichen Gase und andere Bestandteile einer Turbulenz, sowie Plasmoide, kohärente, von sehr starken Magnetfeldern eingeschlossene Regionen, die an hochenergetischen Reaktionen beteiligt sind.

Forschende modellieren derartig durchdringende, fluid-ähnliche Strukturen mit Hilfe von Magneto-Hydrodynamischen Gleichungen (MHD). Auf einem Supercomputer erstellen sie dafür ein Gitter und lösen diese Rechnungen in jeder Zelle. Diese geben wiederum Aufschluss darüber, wie Magnetfelder, Teilchen und Gas sich im ISM gegenseitig beeinflussen. Je feiner das Gitter, desto mehr Physik lässt sich in die Simulation einbinden – allerdings steigt mit der Zahl der Gitterpunkte und Berechnungen auch der Aufwand erheblich an: „Turbulenz im ISM hat keine definierte Geometrie oder Symmetrie, die sich zur Vereinfachung nutzen ließe – man muss den Code also wirklich optimieren und die Berechnungen mit einem brute-force-Ansatz angehen“, erläutert Cielo.

Um besser zu erkennen, wie magnetische Turbulenz das ISM beeinflusst, entwickelte das Team ein hochauflösendes Gitter mit 10.080 Einheiten pro Dimension und modellierte einen würfelförmigen Bereich des ISM von etwa 30 Lichtjahren Kantenlänge, groß genug, um Strukturen wie extrem dichte Regionen sowie Leerstellen oder Plasmoide, eine Art eingeschlossener, magnetischer Blasen, zu erfassen und statistische Daten zur Ausrichtung der Magnetfelder mit den Strömungen zu liefern. Das so berechnete Modell kann jedoch herunterskaliert werden, um außerdem feinere Phänomene wie Sonnenwind und Plasmaausbrüche zu untersuchen, die sich auf die Raumfahrt oder Satelliten auswirken.

Im Astrolab am LRZ arbeitet Cielo eng mit Forschenden zusammen, die Rechenzeit an den LRZ-Supercomputern für astrophysikalische Projekte bekommen haben. Der HPC-Spezialist unterstützte Beatties internationale Gruppe bei der Optimierung ihres Codes, damit dieser auf 140.000 Kernen von SuperMUC-NG Phase 1 – sie machen etwa die Hälfte des Systems aus – ausgeführt werden konnte. Das Team setzte dabei auf Mixed-Precision-Algorithmen, eine Optimierung, die auch in Machine-Learning- und KI-Anwendungen genutzt wird, um die Speicherlast in weniger kritischen Bereichen der Simulation zu reduzieren und dafür im Gegenzug mit mehr Rechenressourcen die Simulation zu vergrößern.

Cielo war zudem verantwortlich für eine interaktive, dreidimensionale Visualisierung der Simulationsdaten, die Hunderte von Rechenknoten auf SuperMUC-NG Phase 1 beschäftigte und mit Grafikprogrammen diese noch besser veranschaulichte. Zusammen mit einer detaillierten 2D-Darstellung von Beattie ermöglicht diese Visualisierung nun neue Einblicke in die Veränderung der Turbulenz durch Magnetfelder: Sie zeigen, dass diese den Energietransfer im ISM beeinflussen, indem sie kleinste turbulente Bewegungen unterdrücken. Gleichzeitig verstärken die Magnetfelder die sogenannten Alfvén-Wellen, das sind niederfrequente Störungen, die wiederum durch Magnetfelder im Kosmos angetrieben werden. Diese Ergebnisse deuten darauf hin, dass Magnetfelder generell eine größere Rolle bei der Stabilisierung des ISM gegen übermäßige Fragmentierung spielen könnten als bisherige Modelle vermuten ließen Was wiederum neue Wege zu genaueren Simulationen magnetischer Turbulenz eröffnet. „Mit dieser extrem hochauflösenden Arbeit können wir qualitativ neue Vorhersagen treffen, die uns der Entschlüsselung des Rätsels um Stabilität und Energieübertragung im ISM einen Schritt näherbringen“, meint Cielo. „Das Problem magnetisierter Turbulenz berührt grundlegende Fragen von mehreren Teilbereichen der Physik, und wir hoffen, dass unsere Arbeit viele Wissenschaftlerinnen inspiriert, weiterzulesen und zu forschen und mit dem LRZ für mehr spannende Astro- Projekte in Kontakt zu treten.“

Cielo und Beatties Team arbeiten daran, aus ihren Erkenntnissen weitere Simulationen für die LRZ-Ressourcen abzuleiten. Während das Rechenzentrum SuperMUC-NG Phase 2, ein Upgrade seines Flaggschiffsystems, auf den Betrieb vorbereitete, passte das Team seine Simulations-Anwendungen an die Nutzung der darin verfügbaren Graphics Processing Units (GPU) an. „Die nächste Generation von HPC bringt neue Aufgaben für den Nutzer-Support“, sagt Cielo. „Software auf GPUs zu portieren, ist kein Selbstläufer, sondern erfordert neue Anstrengungen.“ Der Computerspezialist und das Forschungsteam evaluieren bereits verschiedene Möglichkeiten, ihre Astro-Codes mit GPU auszuführen sowie die Ergebnisse mit der Leistung von GPU-Alternativen zu vergleichen. Dabei werden auch KI-beschleunigte Algorithmen auf ihre Tauglichkeit hin analysiert. Sie könnten helfen, Speicherplatz in Rechenkapazitäten umzumünzen und damit Engpässe beim Supercomputing zu überwinden, die durch häufige Datenzugriffe entstehen.

Für Cielo schätzt das fokussierte Vorgehen der Forschungsgruppe um Beattie – und freut sich schon auf weitere Kooperationen: Das Astrolab am LRZ und seine Kolleginnen unterstützen die Forschenden künftig bei der Optimierung von Codes und bei der Visualisierung von Simulationsergebnissen. So lässt sich das gewonnene Wissen um Turbulenzen weiter vertiefen. „Die Gruppe nutzt gut optimierte Anwendungen, und wir schaffen das Rechenumfeld dafür – bieten die Software, Compiler und alles Weitere für eine effiziente Ausführung auf unserer Hardware“, sagt Cielo. „SuperMUC-NG Phase 1 und 2 sind für diese Art von Simulationen ideal geeignet. Mit einem großartigen Forschungsteam und einem guten Code kann man zu rechnerischen Höhenflügen aufsteigen.“ Eric Gedenk | GCS

Bildnachweis © James Beattie | Princeton University